01:30 min

01:30 min

Sunrise System

24.06.2021

Sunrise System

24.06.2021

Roboty wyszukiwarek internetowych podczas wejść na stronę w pierwszej kolejności szukają na serwerze pliku o nazwie robots.txt. Jest to plik działający w oparciu o protokół Robots Exclusion Protocol, czyli mechanizm informujący boty o tym jakie części serwisu są zablokowane przed indeksowaniem – co oczywiście ma istotny wpływ na pozycjonowanie stron. Plik robots.txt powinien być umieszczony w głównym katalogu domeny.

Z punktu widzenia pozycjonowania przyczyn jest kilka. Najczęściej chodzi o blokowanie stron tworzących duplicate content, katalogów zawierających prywatne pliki oraz stron w przygotowaniu.

Tworzenie i edycja pliku robots.txt jest dziecinnie prosta. Wystarczy nam do tego najprostszy edytor tekstu (np. notatnik). Oto przykładowa postać pliku:

User-agent: *

Disallow: /

Taki zapis spowoduje zablokowanie całego serwisu dla wszystkich robotów wyszukiwania. Jeśli chcemy zablokować dostęp tylko dla wybranych botów lub tylko części serwisu, należy użyć odpowiednich wartości:

User-agent: googlebot

Disallow: /private/

Ten zapis zablokuje dostęp do folderu private tylko dla botów Google.

Jeśli nie chcemy, aby obrazy z naszej strony pojawiały się w wynikach wyszukiwania grafiki w Google, musimy użyć zapisu:

User-agent: Googlebot-Image

Disallow: /

Plik robots.txt dla sklepu internetowego na przykładzie eCommerce:

User-agent: *

Disallow: /*?osCsid

Disallow: /*buy_now

Disallow: /*add_product

Powyższy zapis spowoduje zablokowanie indeksowania stron z identyfikatorem sesji sklepu osCommerce oraz koszyka, który przyczynia się do wzrostu ilości stron duplicate content w serwisie.

Jeśli nie mamy możliwości stworzenia pliku robots.txt lub po prostu nie chcemy blokować stron przy pomocy tego rozwiązana, istnieje możliwość zablokowania indeksacji strony np. poprzez zapis w sekcji HEAD.

Sprawdź w 90 sekund, jak Twoja strona radzi sobie w sieci!

Pod lupę bierzemy aż 70 różnych parametrów.

Odbieraj regularną dawkę wiedzy i nowości ze świata digital marketingu!

Zero spamu, tylko konkrety!

8:30 min

08.07.2021

Sieci neuronowe, nauczanie maszynowe i AI to pojęcia, które z roku na rok nabierają coraz większego znaczenia w kontekście SEO. Zarówno Google, jak i czołowi giganci e-commerce wykorzystują rosnący potencjał sztucznej inteligencji. Zastanawiasz się, jak nowoczesna technologia wpływa na marketing internetowy i pozycjonowanie? Odpowiedź znajdziesz w poniższym artykule.

8:30 min

08.07.2021

Sieci neuronowe, nauczanie maszynowe i AI to pojęcia, które z roku na rok nabierają coraz większego znaczenia w kontekście SEO. Zarówno Google, jak i czołowi giganci e-commerce wykorzystują rosnący potencjał sztucznej inteligencji. Zastanawiasz się, jak nowoczesna technologia wpływa na marketing internetowy i pozycjonowanie? Odpowiedź znajdziesz w poniższym artykule.

5:00 min

07.10.2021

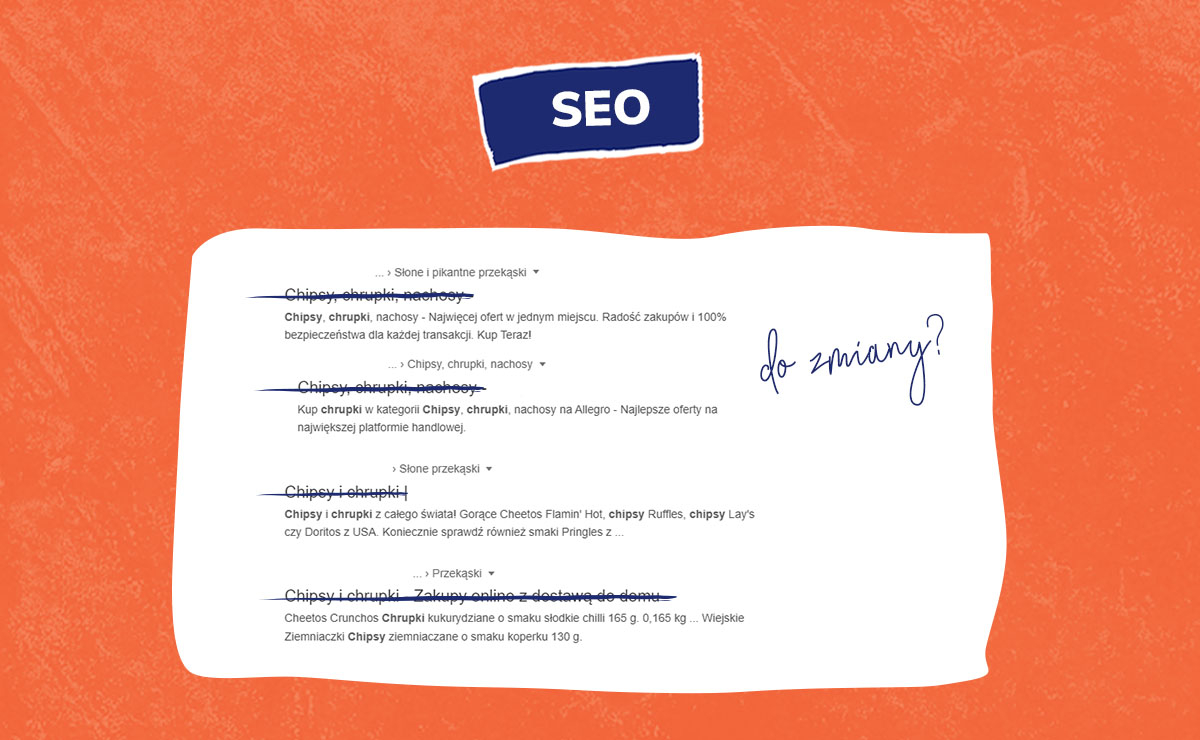

Google przyzwyczaił nas już do zmian, co nie znaczy, że należy tracić czujność. Każdą zapowiedź nowości ze strony Google warto uważnie śledzić. Na tym tle w ostatnim czasie dość mocno wybiła się informacja o aktualizacji metody wyświetlania tytułów stron. Co tak naprawdę zmienia się w znacznikach title? Czy ta zmiana wpływa na pozycjonowanie? Tematowi przyjrzał się nasz ekspert SEO.

5:00 min

07.10.2021

Google przyzwyczaił nas już do zmian, co nie znaczy, że należy tracić czujność. Każdą zapowiedź nowości ze strony Google warto uważnie śledzić. Na tym tle w ostatnim czasie dość mocno wybiła się informacja o aktualizacji metody wyświetlania tytułów stron. Co tak naprawdę zmienia się w znacznikach title? Czy ta zmiana wpływa na pozycjonowanie? Tematowi przyjrzał się nasz ekspert SEO.

11:00 min

06.05.2021

Pozycjonowanie stron internetowych to proces skomplikowany, obejmujący szereg działań on-site. Bardzo duże znaczenie w SEO mają kody odpowiedzi HTTP. Stanowią one istotną informację dla webmasterów i specjalistów ds. pozycjonowania. Co to jest status HTTP? W jaki sposób wpływa on na widoczność strony w wynikach wyszukiwania? Już teraz poznaj odpowiedzi na te pytania!

11:00 min

06.05.2021

Pozycjonowanie stron internetowych to proces skomplikowany, obejmujący szereg działań on-site. Bardzo duże znaczenie w SEO mają kody odpowiedzi HTTP. Stanowią one istotną informację dla webmasterów i specjalistów ds. pozycjonowania. Co to jest status HTTP? W jaki sposób wpływa on na widoczność strony w wynikach wyszukiwania? Już teraz poznaj odpowiedzi na te pytania!

20:00 min

28.09.2023

Optymalizacja strony pod kątem SEO to proces długofalowy. Wymaga umieszczenia każdej nowej treści w odpowiednim miejscu struktury. Jak wesprzeć proces pozycjonowania?

20:00 min

28.09.2023

Optymalizacja strony pod kątem SEO to proces długofalowy. Wymaga umieszczenia każdej nowej treści w odpowiednim miejscu struktury. Jak wesprzeć proces pozycjonowania?

Na dobry start

proponujemy Ci bezpłatnie: